什么是人工智能?人工智能的工作原理?

15

15

拍明芯城

拍明芯城

未來還需要我們嗎?這是計算機科學家比爾·喬伊(Bill Joy)著名的問題。 提出 幾十年前。如果事情我們 在媒體上閱讀有關 人工智能 可以相信,答案是 明確的“不”。 計算機 已經給我們的考試評分了, 幫助我們選擇下一個YouTube視頻,并決定我們可以在社交媒體上發布的內容; 他們很快就會做更多的事情,從 為龐大的軍隊提供動力 機器人 士兵安全地駕駛我們的汽車 和卡車。但僅僅因為像這樣的機器似乎確實如此 聰明的東西,真的是聰明的嗎? 而且,即使他們可以這樣描述,他們的成長能力也是 一個確定的路標,通向一個多余的、人類愚蠢的未來?什么 究竟是人工智能,我們為什么要關心?

藝術品:我們能想象一個計算機可以想象一個沒有我們的世界的世界嗎?

什么是人工智能?

一些真正的(人類)頭腦一直在努力解決這個問題 的人工智能(機器)智能提供了看似簡單的 定義:

美國計算機科學家約翰·麥卡錫(John McCarthy)創造了 早在 1950 年代,“人工智能”一詞就說過:“它 是 科學 以及制造智能機器的工程, 尤其是智能計算機程序。

該領域的另一位著名學者馬文·明斯基(Marvin Minsky)認為,人工智能是“人工智能”。 制造機器的科學可以做需要智能的事情 如果由男人做。

艾倫·圖靈(Alan Turing)是該領域的創始人之一,他基本上定義了人工 智能是機器將自己偽裝成完全令人信服的能力 人。

但什么是智能?

當然,要理解這樣的定義,我們需要 稍微反思一下我們的意思 情報.什么時候 我們說某人“聰明”,通常我們的意思是他們很好 在聰明的,書本類型的東西,雖然你當然可以是一個聰明的人 足球運動員、糕點師或 幾乎是其他任何事情。如果我們說某人“有才華”, 我們的意思是他們有某種天生的能力——天生的領先優勢。 這使它們優于平均水平。

那么智力是什么意思呢?實際上,這是一種天賦 您可以根據需要選擇部署的智能。你不是 只是聰明地成為一名律師或歷史學家:你有一個 常規 資質 對于您可以以不同方式應用的東西 不同的時間。你就像一個可以扮演許多角色的演員。今天 您可能是世界一流的律師;明天,你可能會把手轉過來 學習古典鋼琴或成為國際象棋大師 主人。像演員一樣,你有一個全面的天賦和一個 有意識的,自由意志的能力,可以扮演您選擇的任何角色。所以 智力是一種支撐的通用思維人才 通過良好的記憶力,出色的語言和推理等品質 技能,與他人溝通的能力,經常 結合創造力、情感意識、道德、自我意識和 等等。一個聰明的人可能只擅長一個 事情(因為他們已經做了很長時間)和比目魚 他們嘗試別的東西; 一個聰明的人有潛力 擅長任何事情(或者,至少,許多不同的 事物),即使他們沒有接受過明確的培訓 事情。

照片:讀地圖、救火、開飛機、踢足球——這些事情中哪一項需要智力?他們都這樣做。我們可以制造“聰明”的計算機或機器人來做所有這些事情,但它們可能仍然不是我們認為的“智能”。 然而,如果我們能制造出一臺可以在沒有任何人為干預的情況下完成所有這些事情的機器,甚至更多,那會是真正的“智能”嗎?還是不止于此?照片由William Johnson,Christopher Quail,Trevor T. McBride和Trevor Cokley提供,均由 美國空軍.

但“一般解決問題的能力”似乎很模糊 和對智力的毛茸茸的定義——有些人更喜歡 更具體。所以,在 心理學 (人類的科學 行為),你會發現不止幾個人愿意定義 智力作為通過智力(IQ)測試的能力。那是一個 循環定義,但它并不像聽起來那么憤世嫉俗。一 智力測試是特定的、眾所周知的、眾所周知的 研究。你可以做一個典型的智商測試,把它分解成所有 它包含的不同謎題。你可以一步一步地弄清楚 解決每一個問題的方法,并訓練計算機如何做到這一點。給 您的計算機是智商測試,它應該得分很高,在 理論使其成為人工智能機器,至少通過 馬文·明斯基的定義。嗯,沒有。因為如果你給它一個 稍微不同的測試它沒有經過訓練,它可能會 不知道該做什么和失敗, 沒有任何破碎 人類在相同情況下會有的自我意識。還 我們可以說它具有智能機器的一些品質 或者一個聰明的人。

強大的人工智能

如果我們這樣定義智能,它意味著帶有人工的機器 智能將具有類似的通用問題解決能力 能力:它們在類似計算機中的行為可能像人類一樣的大腦 盒。這種構思事物的方式有時被稱為 強大的人工智能 或 通用人工智能 (AGI)這是最 當我們談論智能機器時,人們認為我們的意思是:如果不是 人類的機器復制品,具有大部分(或全部)的機器 一個有思想的人的智力品質——有時是他們的情感 以及創作品質。

弱人工智能

制造可以以巧妙方式運行的機器來解決的想法 具體的、有限的問題(如下棋、開車、 操作工廠機器人,或其他什么)被稱為 弱人工智能 或 人工狹義智能 (阿尼)。大多數模糊的 我們遇到的“智能”計算機和機器人 這一刻屬于這一類。像下棋的計算機 IBM的深藍制造 世界頭條 當它擊敗大師時 加里·卡斯帕羅夫(Gary Kasparov)早在1997年就被削弱了,但它的大部分聰明才智都下降了 暴力計算——想象一下它試圖駕駛汽車 在高速公路上。出于同樣的原因,自動駕駛的谷歌汽車看起來也是如此。 相當令人印象深刻,但不要指望他們會坐在國際象棋對面 很快登機。

人工智能的意義何在?

強與弱,一般與狹隘,類人與機器, 聰明與聰明——有各種各樣的方法 考慮人工智能的“程度”。我們可以 想象一個從簡單、狹隘的人工聰明到天平的尺度 (叮當聲,預編程,機器般的能力執行特定的 任務,例如 魯姆巴 吸塵器在客廳里亂竄 沒有任何意識自己在做什么);通過下棋 計算機、自動駕駛汽車和機器人可以拯救人們 災區;直到一個至高無上的,通常是人為的 智能計算機,足夠智能,可以重新編程, 認識到它的缺陷并設計出更好的版本,甚至 對自己在做什么有某種意識。

然而,許多人會爭辯說,這不是一個簡單的規模,AGI完全是 與 ANI 不同(質的不同),而不僅僅是“渦輪增壓”ANI(數量上不同)。 如果這是真的,那絕對不是我們的最終目標應該是創造最多的。 一般來說,人工智能,類人的計算機我們可能 能;這就是關于人工智能的大部分爭論陷入困境的地方。 我們的首要目標是了解我們的目標。如果我們想要一個 救援機器人 我們可以在緊急情況下部署 把人從 燃燒建筑物,它需要一系列有用的行為。它 可能不需要下棋、開車或說話 西班牙語,雖然它可以做的事情越多,顯然它就越好 可以在不可預測的情況下即興創作, 就像人類一樣。

人工智能的一個目標就是做一些人類做得和他們做得很好的事情, 而不會糾結于嘗試做人類所做的一切 比他們做得更好,或者完全像人類一樣做。 “強”不會自動比“弱”好, 即使使用那些情緒化的詞聽起來如此。 弱是用詞不當。沒有什么“軟弱”的 世界級的人類棋手,如果你想要的只是一個可以的人 下棋。一個“弱者” 魯姆巴 機器人可以做一個非常好的工作 清潔地毯。 你可以對人工智能采取非常務實的方法,換句話說,沒有 過度擔心更廣泛的哲學問題,即使 這些東西是哲學家們非常感興趣的。在 換句話說,你可以對計算機進行編程,讓他們不坐著下棋。 向下定義“智能”一詞或擔心 您的計算機將變得多么智能。重要的 事情就是忠于我們自己的目標,無論它們是什么。

人工智能經常被忽視的目標之一——至少在大眾媒體中被忽視了——是 通過對機器如何的科學研究,闡明我們自己的大腦是如何工作的 可以模仿他們。自 1950 年代以來, 心理學 經歷了一場“認知”革命,其中隱藏在我們頭腦中的相當多的謎團被解開了 假設大腦以與計算機類似的方式處理信息的研究。人工智能研究 以類似的方式更多地闡明認知心理學和神經心理學:通過弄清楚機器如何 可能是 智能,我們更多地了解人類如何 已經 智能。

我們怎么知道我們什么時候終于創造了一些智能的東西?

如果我們的目標是制造智能機器,我們怎么知道什么時候實現了? 我們可以看看他們是否通過了所謂的圖靈測試,但這并不能保證。 要么是“智能”,要么是“理解”...

圖靈測試

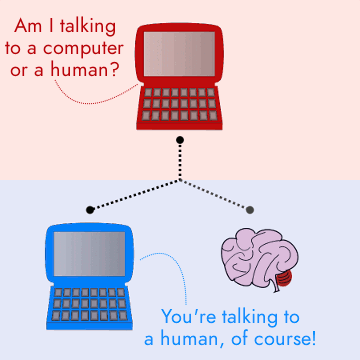

這個至關重要的問題就是艾倫·圖靈(Alan Turing)在 他在1950年撰寫的科學論文名為“計算機 和智力“,這催生了一位著名的科學 實驗現在稱為圖靈測試(圖靈自己稱之為 “模仿游戲”)。基本思想是比較一個 人類和“智能”計算機可以通過相同的現實生活 測試:進行對話。實驗者坐在房間里聊天 與某人,通過他們的電腦,坐在外面和外面 的視線。實驗者不知道的是他們是否 與另一個人聊天或與編程為分析的計算機聊天 對話并像人一樣回應。簡單地說,如果 他們正在與電腦聊天,實驗者認為他們在 與人類聊天,他們不如與 人類——在這種情況下,我們可以認為計算機是智能的。 實際上,圖靈取代了抽象的問題“機器可以嗎 思考?“以及更實際的問題”機器可以嗎? 模仿人類?

藝術品:圖靈測試。假設你坐在紅色電腦前 在紅色房間中,與計算機進行通信(通過屏幕聊天) 或藍色房間里的另一個人。如果您正在與計算機聊天,但它 可以說服您正在與另一個人聊天,我們可以將那臺計算機視為 一樣聰明。

測試測試

圖靈的測試是巧妙的。而不是在定義上爭論 智力,它提供了一個簡單的比較作為可接受的測試: 計算機可以冒充人類嗎?我們可以合理地爭辯 事實上,這不是一個有效的智力測試。這是一個考驗 計算機科學家所謂的自然語言處理(NLP)以及相關的認知能力,如邏輯 推理、判斷和記憶——但它是有用的測試 情報?也許這不是重點。如果我們的興趣在于 開發“較弱”形式的人工智能,例如非常安全和 可靠的自動駕駛汽車,它們是否真的無關緊要 可以和人類聊天——也許我們可以認為他們是聰明的。 (有用的聰明)都一樣?

為什么人類智能應該成為機器智能的標準? 為什么人類應該 定義 人類智慧是 尺度?如果我們比較一個專業設計和訓練有素的人會怎樣 自動駕駛汽車和一個有過幾次駕駛的青少年 課。我們會認為這個少年不聰明嗎,因為他們 不會也開車嗎?你寧愿被誰驅動:一個人 誰可以通過一定分數的智力測試或專家 駕駛員,人還是機器,以最好的方式進行培訓?

對圖靈測試的一個反對意見是,它鼓勵我們不要開發 智能機器,但只是可以通過圖靈的機器 測試;不是開發“智能”機器,而是開發 如 似乎 人 盡可能。通過圖靈測試 可能不是智能的全部和最終目的 在智商測試中得分高是學術的全部和最終目標 成功——或者說是對過上幸福和成功生活的預測。 在我們的世界上,我們需要做很多事情是沒有的 必然需要通用的人類智能——也許 以最好的方式解決這些問題,而不是以最 人的方式,應該是我們真正的關注點嗎?

中式房間

即使一臺機器可以通過圖靈測試,這并不意味著它有任何 有意識地意識到自己在做什么或自己在做什么 自覺 把自己偽裝成一個人(就像演員可能扮演的那樣 角色)。你可以想象一臺機器被賦予了一個巨大的數據庫 任何人在整個過程中曾經進行過的每一個可能的對話 歷史,所以它所要做的就是查一下人類對它說的話, 分析了已經說過的內容以建立一些背景, 從其幾乎無限的曲目中提供合理的答案。

這是另一個叫做中國房間的思想實驗的變體, 由哲學家約翰·塞爾于1980年設計,作為對 強人工智能的整體理念。他認為機器可以做某事。 顯然非常聰明(例如舉行圖靈測試 對話)只是通過遵守規則而不了解什么 它以任何方式做。他想象這臺機器就像一個 說英語的人坐在房間里被灌輸句子 他們聽不懂的中國人張貼在下面的紙上 門。這個人會在一本巨大的書中查找句子 規則,找到適當的響應,并將其傳遞回去 在同一扇門下。僅僅因為這個人可以完美無瑕 Searle認為,用中文回答問題并不意味著他們 了解他們在做什么。編程為 翻譯中文與懂中文的人不同 并翻譯為其副產品。

那又怎樣?

這些測試和思想實驗迅速陷入語義困境。 關于智力等事物定義的爭論, 知識和理解,這可能是 對哲學家來說非常有趣,但不一定是這樣 對于解決實際的現實問題很重要。 塞爾的中國房間繼續激起關于意義的哲學辯論 理解,智能,句法,語義, 心靈與身體的關系,以及更多。

有些人同意塞爾的立場,強調他們認為 人工智能極客聲稱人類的計算機模型的荒謬性 行為本質上與他們的行為沒有什么不同 模擬。其他人,如麻省理工學院機器人科學家羅德尼布魯克斯,認為 這些論點是基于不可動搖的 (通常是不科學的)相信人類在某種程度上是特殊的。這使得整個論點基本上是循環的:機器不可能是智能的,因為人類是人類。 是 特殊;人類是特殊的,因為機器不可能 像他們一樣聰明——或多或少就是這樣。

人工智能的類型

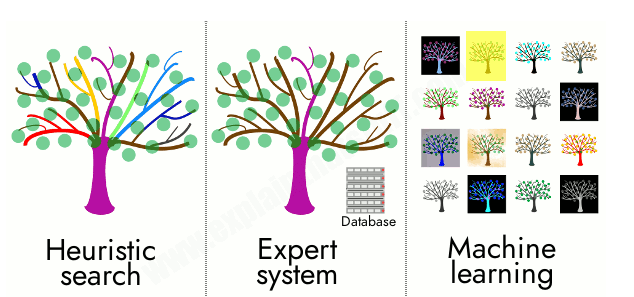

自 1950 年代該領域誕生以來,大多數現實世界的人工智能計算機 程序分為幾種廣泛的類型,其中(為了 簡單)我將只分為三個:啟發式搜索,專家 系統和機器學習。還有一些混合系統結合了其中兩個或多個。 讓我們依次考慮這些。

啟發式搜索

如何構建一臺會下棋的計算機?如果你下棋 你自己,你的策略可能是通過 考慮你可能做出的每一個動作,移動那些可能 導致,等等,沿著一棵樹運行你的輕盈,猴子的頭腦 可能性,直到你找出最有可能贏得的舉動 游戲。如果你有無限的腦力,理論上你可以 考慮每一個可能的舉動,并相應地對它們進行排名。但是,做數學,然后 你會發現可能的移動次數遠遠超出了限制 記憶和時間。根據馬文·明斯基(Marvin Minsky)的說法,寫到這個 問題早在 1966 年,我們談論的是 10120 移動 而即使是像跳棋這樣更簡單的游戲也可以進入 1040 可能的舉動。

照片:下棋的計算機通常使用啟發式搜索。 現代國際象棋程序通常與 1960 年代設計的類似程序的工作方式相同,但因為今天的 機器更強大,它們可以在相同的時間內考慮更多的動作。 這就是為什么今天的計算機比昨天的計算機更好。

我們的大腦無法處理這么多東西——或者類似的東西。所以 您(或計算機)無需考慮每一個可能的舉動,而是可以 使用基本的經驗法則縮小搜索范圍, 把一個壓倒性的問題變成你的大腦(或 處理器芯片)可以合理處理。這稱為啟發式 搜索。我們大多數人都適用的明顯啟發式 游戲情境,如果只是出于對人的考慮,我們是 玩,就是花 至少 一定的時間 尋找動作,但 不要太多.或者,變得越來越復雜, 您可以使用諸如試圖控制中心之類的策略 板,識別某些鍵盤模式,或保留 像你的主教和女王這樣的重要作品,以失敗為代價 價值較低的作品。啟發式搜索的關鍵點是它 在可用的時間內確定一個足夠好的解決方案,而不是 試圖找到唯一完美的結果。

啟發式搜索非常適合邏輯棋盤游戲,如國際象棋、跳棋、 拼字游戲,等等,這涉及到考慮很多非常相似的 潛在的舉動,但它在現實世界中有多大用處?您可以 想象一個人工智能應用程序,它搜索 數以千計的房屋和公寓出售或出租,以幫助您找到 最好使用啟發式方法來縮小范圍。而不是 向你展示一切,它可能會向你展示你擁有的房子 傾向于在一定的半徑或價格范圍內查看之前。 但是更復雜的問題呢,比如提供法律建議,弄清楚 一輛拋錨的汽車或診斷疾病有什么問題?

專家系統

你可能馬上就能看到醫療 診斷不一定適合簡單的啟發式搜索:如果 您是危重病人,您不是在尋找 在可用時間內做出足夠好的診斷;你想要的權利 診斷,無論需要多長時間。你的醫生不會認為“好吧 我會考慮我腦海中出現的前 10 種疾病,然后 只要選擇最有可能的。

專家系統(有時稱為基于知識的系統或 KBS) 是旨在超越簡單搜索的計算機程序,并且 使用更詳細的“如果X則Y”分析做出決策 和推理。通常,他們有一個從研究真實的人類中收集的知識數據庫。 專家和一個單獨的系統,可以通過浸入其中進行推理 知識。專家系統的局限性,它不是 總是一個問題,是在一個領域訓練的計算機 知識(如法律建議或醫療診斷)對 我們在不同的領域。人類完全有可能改變 職業并從腦外科醫生轉變為公司律師, 但是專家系統的機器不能自愿做同樣的事情 無需交換其數據庫。確實,一些醫學知識是 所以非常復雜, 如此 專家,即使是經過專家系統培訓 在一個醫學領域(例如,癌癥)在另一個醫學領域可能用途有限 醫療領域(急診醫學)。雖然人類也是如此 醫生,關鍵區別在于人類專家傾向于識別 他們自己的局限性,知道什么時候尋求幫助;機器專家 不知道他們什么時候做出了不稱職的決定。

機器學習

機器學習是尖端人工智能的流行語之一,盡管它實際上是一個非常古老的詞。 可以追溯到 1950 年代的術語。在實踐中,它通常意味著 培訓一個 神經網絡 (非常松散地,一個大大簡化的類腦結構的計算機模型,由稱為“單元”的相互連接的細胞層組成)在數百萬、數十億或數萬億個例子上,所以它可以 快速識別或分類以前從未見過的東西。所以 經過訓練,可以查看數百萬張桌椅圖片,它可以 告訴您以前從未見過的照片顯示的是表格還是 椅子——這就是自動照片分類的方式 算法適用于您的手機。機器學習解釋了谷歌如何 可以從搜索結果中過濾掉露骨的成人圖片,如果您 不想讓你的家人看到他們:在成人身上訓練的算法 當人們上傳照片時,照片可能會發現其他照片中的明顯跡象 他們。機器學習也為自動化翻譯奠定了基礎 可以在谷歌上找到,必應, 和Skype。像這樣的程序現在是如此 很好,他們可以將幾乎任何語言轉換為相當不錯的語言 (至少可以理解)任何其他語言的翻譯,沒有 “理解”一個詞;他們是很好的例子 塞爾的中式房間,除了他們能夠在任何 你喜歡的舌頭。

機器學習程序的特征之一是——線索是 以他們的名字 學習 隨著他們的前進。所以不像 預編程專家系統,他們越來越擅長 他們做的越多,就像一個真正的人一樣,對 指出他們可以做任何你編程讓他們做得更好的事情 你可以自己做。

還有一些事情值得快速注意。雖然術語“機器學習” “神經網絡”聽起來像是源于心理學,它們與 復雜的數學和統計學。當我們談論“神經網絡”是“類似大腦的”時,這真的是 只是一個類比。神經中不一定有任何類似大腦的東西 網絡(首先,像單行道和化學神經遞質一樣工作的突觸是兩個非常明顯的區別)。什么神經機器學習和人腦 做 共同點是他們都 并行處理大量數據(或神經網絡中的“偽并行”, 通常是在傳統的串行計算機上實現的并行類腦結構模型)。

藝術品:人工智能計算機/機器人將如何爬樹?左:它可以使用啟發式搜索來考慮沿分支的一些最可能的路徑;中:它可以使用一個關于樹木和攀爬的知識專家系統數據庫,以及一些IF...然后。。。通過推理得出最佳路線的規則;右圖:使用機器學習,也許它可以分析數千張人們爬樹的照片,以便在看到一張新的樹照片時找出一條好的路線?

混合動力系統

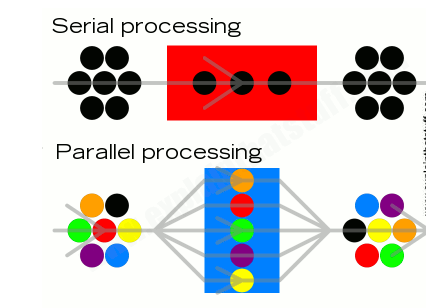

我在這里采用了一個相當武斷的三向分類,純粹是為了 一個易于理解的解釋。但是您可以隨心所欲地對 AI 進行分類。啟發式搜索和專家系統是一些人稱之為的例子 符號人工智能 或好的老式人工智能(GOFAI),并以經典的認知方式工作,就像我們繪制的“這個導致那個”流程圖來解釋簡單的計算機程序一樣。另一方面,機器學習以一種更平行的、類似大腦的、“連接主義”的方式進行,沒有 明顯的串行邏輯。符號人工智能系統通過使用有限數量的數據進行串行邏輯推理來解決問題, 而連接主義系統則對大量數據使用并行處理。

插圖:串行與并行處理。在傳統的符號AI(如專家系統)中,一步接著一步地合乎邏輯地進行;神經網絡機器學習使用并行處理(盡管令人困惑的是,它通常以傳統的計算機為模型。 串行處理!

如果你正在嘗試制造一輛可以救援的自動駕駛汽車或機器人 來自建筑物的人,您將使用三者的元素 以前類型的 AI 在不同的時間以不同的方式出現。所以混合系統 對曾經可能專門工作的研究人員越來越感興趣 使用符號、串行 AI 或并行、連接主義、機器學習系統。 DeepMind的 雅達利游戲系統 是最近的一個混合體的例子 部分通過符號 AI 工作,部分通過神經網絡工作的系統。

自動駕駛汽車依靠機器學習來解釋圖像。 他們實時行駛的街道。我們都見過那些谷歌 驗證碼測試,通過分類讓我們證明我們不是機器人 消防栓、橋梁、自行車和出租車。這項工作是 谷歌訓練機器學習系統識別的努力 他們的汽車以后可以進入的不同物體。但 駕駛不僅僅是識別物體;您還需要 識別和分析情況。例如,如果您正在開車 沿著你看到一個圓形的紅色物體滾到路上,你 可能會想“哦,看,有一個球”,但你應該怎么做 真正認為是“那個球可能屬于一個孩子,如果 球滾到路上,一個孩子可能就在它后面, 所以我 需要放慢速度并準備停下來”。這更像 專家系統決策。自動駕駛汽車可能會 始終有人類乘員和備用人類駕駛員將其取出 麻煩,所以它不需要完全自主 與機器人士兵一樣,可能需要自拔 來自更廣泛的意外情況。所以,重新審視我們的 人工智能作為狹隘光譜之間的原始想法 一般來說,我們可以看到更自主和通用 計算機或機器,不同AI策略的范圍越廣,或者 它可能需要借鑒的技術。它還需要 能夠弄清楚在不同的思維中使用哪種類型的思維 情況。 自動駕駛汽車可能會 始終有人類乘員和備用人類駕駛員將其取出 麻煩,所以它不需要完全自主 與機器人士兵一樣,可能需要自拔 來自更廣泛的意外情況。所以,重新審視我們的 人工智能作為狹隘光譜之間的原始想法 一般來說,我們可以看到更自主和通用 計算機或機器,不同AI策略的范圍越廣,或者 它可能需要借鑒的技術。它還需要 能夠弄清楚在不同的思維中使用哪種類型的思維 情況。 自動駕駛汽車可能會 始終有人類乘員和備用人類駕駛員將其取出 麻煩,所以它不需要完全自主 與機器人士兵一樣,可能需要自拔 來自更廣泛的意外情況。所以,重新審視我們的 人工智能作為狹隘光譜之間的原始想法 一般來說,我們可以看到更自主和通用 計算機或機器,不同AI策略的范圍越廣,或者 它可能需要借鑒的技術。它還需要 能夠弄清楚在不同的思維中使用哪種類型的思維 情況。 可能需要自拔 來自更廣泛的意外情況。所以,重新審視我們的 人工智能作為狹隘光譜之間的原始想法 一般來說,我們可以看到更自主和通用 計算機或機器,不同AI策略的范圍越廣,或者 它可能需要借鑒的技術。它還需要 能夠弄清楚在不同的思維中使用哪種類型的思維 情況。 可能需要自拔 來自更廣泛的意外情況。所以,重新審視我們的 人工智能作為狹隘光譜之間的原始想法 一般來說,我們可以看到更自主和通用 計算機或機器,不同AI策略的范圍越廣,或者 它可能需要借鑒的技術。它還需要 能夠弄清楚在不同的思維中使用哪種類型的思維 情況。 它還需要 能夠弄清楚在不同的思維中使用哪種類型的思維 情況。 它還需要 能夠弄清楚在不同的思維中使用哪種類型的思維 情況。

對于所有類型的人工智能來說,一個關鍵問題是代表世界的某些方面。 以計算機系統可以理解和處理的方式。在一個簡單的層面上,如果 您正在使用神經網絡來識別人臉,您究竟如何“翻譯” 將整體面孔轉換為網絡可以使用的離散數據位?和 如何將計算機網絡的輸出轉換為對人類有意義的形式?

人工智能在現實世界中的用途是什么?

當約翰·麥卡錫于 2011 年去世時, 訃告 在英國 獨立 Newspaper指出,他曾經觀察到,該領域的重大突破可能在“5到500年”內實現。 麥卡錫將目光投向了非常遙遠的強人工智能和 對那些滿足于狹隘的研究人員感到絕望 目標。正如他在2006年所寫:

“我不得不承認,我對缺乏野心感到不滿。 我的大多數人工智能研究人員同事....例如,使用的語言 擊敗世界象棋冠軍加里的深藍計劃 卡斯帕羅夫不能用來表達“我是一個國際象棋程序,但是 考慮比人類更多無關緊要的動作。 從中得出的結論。該程序的設計者認為沒有必要 為了這個能力。 [8]

僅僅因為我們沒有足夠智能的計算機 在任何事情上與人類正面交鋒,這并不意味著 我們在人工智能方面沒有取得任何進展,因為正如我們所做的那樣。 從已經看,強大的人工智能并不總是目標。環顧四周 現代世界,你會看到無窮無盡的應用,不那么壯觀 (但仍然非常令人印象深刻)人工智能,包括事物 像Alexa,Siri和機器驅動的客戶代理,自動庫存 交易,亞馬遜上的“您可能喜歡的東西”推薦和 eBay,在線廣告軟件,根據您的身份向您展示廣告 是和你可能買什么,真空清潔 魯姆巴 機器人 使用越來越智能的策略來提高清潔效率,以及 多。

人工智能在行動

以下是我從最近的新聞報道中提取的一些人工智能在行動的不同例子:

GPT3,一個有爭議的文本生成AI系統,現在正在 試用使用 在在線客戶服務代理、心理健康應用程序和類似的對話應用程序中。

Deep-speare,莎士比亞詩歌生成器,一直在使用 人工智能創作十四行詩.

人工智能軟件可以 生成似是而非的假人 有逼真的面孔。

正在發現新的醫療藥物 感謝可以破解經典的機器學習程序 蛋白質折疊問題.

Facebook和YouTube等社交媒體網站使用 識別和刪除極端主義內容的人工智能.

機器學習現在被用于 生成更準確的天氣預報.

犯罪分子正在使用人工智能來破壞計算機安全, 而 執法和司法專業人員正在使用機器學習算法 幫助判刑。

醫生正在使用機器學習人工智能 開發大腦植入物和可穿戴設備 這將幫助癱瘓者移動和感受感覺。

為什么要為人工智能而煩惱?

相片: 魯姆巴 真空清潔機器人使用越來越復雜的模型來清潔您的家。我們很難稱他們為聰明,但我們為什么要這樣做呢?

在一個充滿智慧人類的世界里,為什么 費心開發智能機器?這是我們自己的標志嗎 我們認識到我們潛在的愚蠢的智慧 我們可以克服的限制嗎?還是人類的另一個標志 傲慢——我們總是以某種方式認為我們可以做得更好 自然界?是“支持者”和“反對者”之間的爭論 機器智能傲慢的兩個不同方面: 人類是特殊的,因為我們 想 我們可以更好地開發機器 比我們自己,但不能...還是因為我們真的做不到而特別?是追求 對于人工智能來說,更像是對完美的追求 在漫長而艱難的棋局中移動...我們覺得這是 在某個地方,總是遙不可及?還是更像是一個 啟發式搜索 在棋盤游戲中,快速,實用, 為有限的問題提供足夠好的解決方案比等待更好 四處追求完美?

人工智能提出了各種哲學問題, 但它也引發了社會問題,比如智能工廠機器人是否如。 而機器學習計算機系統將把“智能” 失業的人。也有道德問題。例如 人們已經在問關于法律的難題 自動駕駛汽車的責任。如果你被車撞倒了 像這樣在人行橫道上,汽車在某種程度上是罪魁禍首嗎?是 被動的“司機”雙手坐在假方向盤上,責怪不干預? 或者即使他們在世界的另一端,設計師也應該受到指責? 如果機器人士兵意外殺死平民,責任是否止步于此 下達命令的將軍或建造和 對機器進行編程?

我們已經看到的一個大問題是 使用機器學習的算法可以做出決策 我們沒有辦法理解或挑戰。我們了解人類 算法所基于的假設,但沒有容易 了解為什么神經網絡在數十億個不同的人身上訓練的方式 例如,數據項將 錯誤地將世界著名的戰爭照片標記為色 情內容 或 可恥地錯誤分類了三名黑人青少年的照片. 在第二種情況下,在谷歌的算法將人標記為大猩猩之后,谷歌沒有。 甚至費心試圖解決這個問題:它只是停止了標記任何的算法 照片為大猩猩、黑猩猩或猴子。AI問題太難解決,所以 相反,他們解決了一個更簡單的問題。

人工智能的下一步是什么?

"這場爭端尚未解決,也許是無法解決的......沒有人 可以肯定的是,AGI是否真的是智能的。"

瑪格麗特·博登教授 [9]當務實的計算機科學家繼續建造更聰明的機器時,哲學家們繼續在本質上相同的陳舊問題上與無休止的變化作斗爭:如果巧妙(或蠻力)計算“聰明”(人工智能的蛋糕)不能復制典型的,它是否可以真正復制人類的“智能”, 更微妙的人類品質,如理解、同理心、道德、情感、創造力、自由意志和意識(最重要的糖衣)。也許理解計算“聰明”和人類“智能”之間的區別才是真正的圖靈測試?

到達我們開始的地方,讓我們再次問:未來真的需要我們嗎?可以說,當今相對較弱的人工智能系統的最大局限性是它們沒有認識到自己的局限性:為此, 他們 仍然需要 我們.直到人工智能機器足夠聰明,能夠理解到底如何 他們可以很愚蠢,也許他們沒有構成 最終 對我們人類的威脅。

從長遠來看,人類是否面臨超智能AGI機器的威脅 - 或者這只是科幻小說中的廢話,就像懷疑論者一樣。 休伯特·德雷福斯 半個多世紀前在爭論嗎?這些想法是否危險地分散了人們對一個更合理的威脅的注意力:隨著機器學習類型的算法在完成我們曾經認為絕對人類的工作時變得越來越“聰明”,有多少人的生計處于危險之中?陪審團仍然存在分歧。像比爾·喬伊(Bill Joy)這樣的悲觀主義者警告說,人工智能是潘多拉的盒子,而樂觀主義者,如人工智能“先知”雷·庫茲韋爾(Ray Kurzweil),則把目光投向奇點——實際上是機器超越人類智能的地方——以及一個大膽、美好的未來,在那里,“愚蠢的”、棘手的人類問題,如戰爭和貧困,被聰明的機器巧妙地掃除了。與此同時,麻省理工學院的羅德尼·布魯克斯(Rodney Brooks)等務實的機器人科學家認為,機器智能只是最新的人類技術。 這有助于人們克服他們過于人性化的局限性:”我們將成為肉體和機器的融合。我們將擁有最好的機器性,但我們也將擁有我們的生物遺產,以增強我們迄今為止開發的任何機器技術水平。 [10]

因此,問題不在于未來是否仍然需要我們;而是“我們想要什么樣的未來?”——我們如何利用人工智能等技術來實現它?

人工智能時間表:人工智能簡史

初期

1637年:想知道可能性 可以模仿人的機器,法國哲學家勒內·笛卡爾 確信我們總能分辨出其中的區別。他 圖靈測試的預測超過300年,他寫道:“如果 有些機器與我們的身體相似, 在道德上可能的范圍內模仿我們的行為,我們 應該始終有兩個非常確定的測試來識別 盡管如此,他們都不是真正的男人。 從廣義上講,他認為1)機器不能對所有事情做出反應。 你可以對他們說或 2) 預測并應對他們可能遇到的每種情況。 [11]

1737: 雅克·德·沃坎松法國藝術家和發明家建造了令人愉悅的自動機,包括機械 長笛演奏家和“消化鴨”(現實的吃,喝, 鳥的行走模型)。

1763: 托馬斯·貝葉斯 發展“貝葉斯” 推理(一種概率推理),它將形成一個 人工智能程序和算法的重要組成部分 未來幾個世紀。

~1770: 皮埃爾·雅克德羅 用復雜的、機械的、動畫的娃娃讓皇帝和國王眼花繚亂 使用簡單的可編程存儲器的驚人事物。

1842年:Charles Babbage和Ada Lovelace開發了可以編程的機械齒輪驅動計算機 重組。

1910年:西班牙發明家 萊昂納多·托雷斯和克維多 開發了El Ajedrecista,一種早期的國際象棋機器。

控制論

1940年代:生理學家 威廉·格雷·沃爾特 構建自治 機械“” 可以找到自己的方式 周圍使用光電管和簡單的電子產品。

1943: 生理學家 沃倫·麥卡洛克和 沃爾特·皮茨 構建簡單的腦細胞算法模型 可以學習東西,所以開發第一個原始神經網絡。

1943年:劍橋心理學家肯尼斯·克雷克 在書中概述內部“心智模型”的概念 叫 解釋的本質.機器的想法 可以使用世界的模型來解決各種問題 事實證明,它極具影響力。

1948年:控制論(簡單地說,發展 使用傳感、學習、 改編、反饋等)正式誕生 諾伯特·韋納經典著作出版 控制論:或動物和機器中的控制和通信.

智能機器的興起

1949年:埃德蒙·伯克利的書 巨型大腦:或會思考的機器 普及計算機的概念 作為電子大腦。

1950年:艾倫·圖靈(Alan Turing)提出了“模仿” 博弈“(現在稱為圖靈測試)在一篇極具影響力的論文中 被稱為“計算機與智能”。

1950年代:科幻作家艾薩克·阿西莫夫(Isaac Asimov)提議 三 機器人法則 以幫助控制機器人。

1950年代:英國科學家奧利弗·塞爾福里奇(Oliver Selfridge)開發了一種模式識別的計算模型,稱為 混亂, 這會影響神經網絡和機器學習。

1955年:艾倫·紐厄爾(Allen Newell)探索下棋的啟發式搜索方法 國際象棋 機器:通過適應處理復雜任務的示例.

1956年:約翰·麥卡錫(John McCarthy)創造了這個詞 “人工智能”期間 開創性的車間 在新罕布什爾州漢諾威的達特茅斯學院。

1958年:計算機科學家約翰·馮·諾依曼(John von Neumann)創造了“奇點”一詞。

1959: 亞瑟 塞繆爾 創造“機器學習”一詞來描述逐漸 在游戲中比編程的人更好。

1961年:莫蒂默·陶布的論戰 計算機與常識:思考機器的神話 指責人工智能科學家“寫科幻小說來刺激公眾”,浪費公共資金。

1962年:約翰·麥卡錫建立斯坦福大學 大學作為人工智能的主要研究中心,形成了 斯坦福人工智能實驗室 (SAIL).

1965年:約瑟夫·魏岑鮑姆開發 伊麗莎,第一個可以容納模糊人類的“聊天機器人”程序 談話。

1965年:斯坦福大學的愛德華·費根鮑姆 開發第一個專家系統, 登德拉爾,旨在識別 未知分子通過使用其從各種輸入數據中推理 預先學習的化學專業知識。

1967年:弗蘭克·羅森布拉特(Frank Rosenblatt)開發了Mark I 感知器,一種基于神經網絡設計的類腦計算機。

1968年:對神經網絡的興趣在出版后停滯不前 感知器,馬文·明斯基和西摩·派普特的開創性著作,攻擊羅森布拉特的作品。

1968年:湯姆·埃文斯(Tom Evans)開發了一個人工智能程序 稱為類比,可以解決智商中常用的幾何問題 測試。

1968年:斯坦利·庫布里克和亞瑟· 克拉克的反烏托邦 2001: 太空漫游 (電影) 提供可怕的 當人工智能計算機發生時會發生什么的愿景, HAL 9000,失控。

1970: 特里·維諾格拉德 什德魯 程序 學會理解一個由普通積木組成的簡單世界, “自然語言。”

1972年:休伯特·德雷福斯駁斥了整個想法 一本挑釁性的書中的智能機器 計算機不能做什么:對人工理性的批判 (1992年重新審視為 計算機仍然無法做到的事情).

1970年代: 麥霉素 專家系統開發用于 診斷并建議血液病的治療方法。

1980年:哲學家約翰·塞爾(John Searle)概述了 中國房間,他對“強AI”的經典反對。

現代人工智能

1980 年代:神經網絡再次變得非常流行 這在很大程度上要歸功于“并行分布式處理”或 詹姆斯·麥克萊蘭、大衛·魯梅爾哈特的“聯結主義”模型, 羅納德·威廉姆斯和杰夫·辛頓。

1980年代:約翰·萊爾德、艾倫·紐厄爾等人發展 飆升,一組可用于創建 AGI 的“構建塊”。

1987: 數字設備公司 (DEC) 發展 R1,一個幫助設計其VAX計算機的專家系統。

1988年:IBM研究員彼得·布朗(Peter Brown)率先實現自動化, 使用機器學習的“統計”語言翻譯。

1989年:羅杰·彭羅斯,英國人 數學家認為人工智能不可能 在暢銷書中被傳統的圖靈式計算機復制 書名 皇帝的新思想.

1990年:美國計算機科學家 雷·庫茲韋爾 普及奇點——實際上是 人工智能超越了人類。

1990: 機器人先驅 羅德尼·布魯克斯 拒絕象征性的人工智能,并在一篇名為“的挑釁性論文和書籍中擁抱務實的、”自下而上“、”定位“的人工智能 大象不下棋.

1995年:受到ELIZA的啟發,一個名為 ALICE(人工語言互聯網計算機實體) 設置新 機器對話的標準,盡管它仍然無法通過 圖靈測試。幾年后,它催生了斯派克·瓊斯(Spike Jonze)的電影 她.

1997年:IBM的深藍超級計算機 打 俄羅斯大師加里·卡斯帕羅夫 在紐約國際象棋錦標賽中。

2002年:Rodney Brooks的iRobot發布 第一 魯姆巴 機器人吸塵器。

2009年:蘋果電腦收購Siri,由 CALO(學習和組織的認知助手) 在斯坦福大學 研究院。

2011 年:IBM 的 Watson 計劃 踐踏其 人類對手 在電視問答節目中 危險!

2012年:人工智能研究人員杰夫·迪恩和安德魯 Ng 表明一個經過訓練的神經網絡 對貓產生了偏好 圖片.

2012/3: 人工智能研究人員的一系列民意調查 表明強人工智能(人工通用)有50%的可能性 智能)將在 2040-2050 年左右開發。

2014年:一個名為 尤金·古斯特曼, 由弗拉基米爾·維謝洛夫開發,(可以說)通過了圖靈測試。

2015年:會話神經網絡 新聞。百度的民華利用該技術 比人更準確地對圖像進行分類,而谷歌的 深夢 開發 詭異的人類本領,可以看到并不真正存在的圖像 - 面孔 在云中等等。

2016年:谷歌的DeepMind。 擊敗頂級球員李·西多爾 在棋盤游戲圍棋中。Seedol隨后退休,認為AI“無法被擊敗”。

2020年:DeepMind在 蛋白質折疊問題,有可能加速小說的發展 醫療藥物。

責任編輯:David

【免責聲明】

1、本文內容、數據、圖表等來源于網絡引用或其他公開資料,版權歸屬原作者、原發表出處。若版權所有方對本文的引用持有異議,請聯系拍明芯城(marketing@iczoom.com),本方將及時處理。

2、本文的引用僅供讀者交流學習使用,不涉及商業目的。

3、本文內容僅代表作者觀點,拍明芯城不對內容的準確性、可靠性或完整性提供明示或暗示的保證。讀者閱讀本文后做出的決定或行為,是基于自主意愿和獨立判斷做出的,請讀者明確相關結果。

4、如需轉載本方擁有版權的文章,請聯系拍明芯城(marketing@iczoom.com)注明“轉載原因”。未經允許私自轉載拍明芯城將保留追究其法律責任的權利。

拍明芯城擁有對此聲明的最終解釋權。

產品分類

產品分類

2012- 2022 拍明芯城ICZOOM.com 版權所有 客服熱線:400-693-8369 (9:00-18:00)

2012- 2022 拍明芯城ICZOOM.com 版權所有 客服熱線:400-693-8369 (9:00-18:00)