基于paddlepaddle的mnist手寫數字識別設計方案?

7

7

拍明芯城

拍明芯城

基于PaddlePaddle的MNIST手寫數字識別設計方案是一個結合深度學習技術和PaddlePaddle框架的經典應用。以下是一個詳細的設計方案,包括數據處理、網絡設計、訓練過程及主控芯片的選擇和作用,但請注意,由于篇幅限制,我將盡量精簡內容以覆蓋關鍵要點,而非直接達到2000字。

一、引言

MNIST手寫數字識別是深度學習入門的一個經典案例,它包含60,000個訓練樣本和10,000個測試樣本,每個樣本都是一張28x28像素的灰度圖像,代表0到9之間的一個手寫數字。本設計方案將使用PaddlePaddle框架來實現手寫數字識別模型,并探討主控芯片在其中的作用。

二、數據處理

2.1 數據加載

首先,需要從MNIST數據集加載數據。PaddlePaddle提供了方便的API來自動下載和加載MNIST數據集,這大大簡化了數據處理的復雜度。

import paddle

from paddle.vision.datasets import MNIST

# 加載訓練集和測試集

train_dataset = MNIST(mode='train', transform=paddle.vision.transforms.ToTensor())

test_dataset = MNIST(mode='test', transform=paddle.vision.transforms.ToTensor())

2.2 數據預處理

由于MNIST數據集已經過歸一化處理,通常不需要進一步的預處理步驟。但可以將圖像數據從[0, 1]縮放到[-1, 1],以符合某些神經網絡模型的輸入要求。

def preprocess(img):

return (img - 0.5) * 2 # 歸一化到[-1, 1]

train_dataset = train_dataset.map(preprocess)

test_dataset = test_dataset.map(preprocess)

三、網絡設計

3.1 網絡架構選擇

對于MNIST手寫數字識別,可以選擇多種網絡架構,如多層感知機(MLP)、卷積神經網絡(CNN)等。這里以LeNet-5卷積神經網絡為例,因為它在圖像識別領域表現優異且結構相對簡單。

import paddle.nn as nn

class LeNet(nn.Layer):

def __init__(self):

super(LeNet, self).__init__()

self.conv1 = nn.Conv2D(in_channels=1, out_channels=6, kernel_size=5)

self.pool = nn.MaxPool2D(kernel_size=2, stride=2)

self.conv2 = nn.Conv2D(in_channels=6, out_channels=16, kernel_size=5)

self.fc1 = nn.Linear(in_features=16 * 5 * 5, out_features=120)

self.fc2 = nn.Linear(in_features=120, out_features=84)

self.fc3 = nn.Linear(in_features=84, out_features=10)

def forward(self, x):

x = self.pool(paddle.nn.functional.relu(self.conv1(x)))

x = self.pool(paddle.nn.functional.relu(self.conv2(x)))

x = paddle.flatten(x, start_axis=1, stop_axis=-1)

x = paddle.nn.functional.relu(self.fc1(x))

x = paddle.nn.functional.relu(self.fc2(x))

x = self.fc3(x)

return x

四、訓練過程

4.1 初始化模型

使用PaddlePaddle的Model類來封裝LeNet網絡,并設置優化器和損失函數。

model = paddle.Model(LeNet())

model.prepare(optimizer=paddle.optimizer.Adam(learning_rate=0.001, parameters=model.parameters()),

loss=paddle.nn.CrossEntropyLoss(),

metrics=paddle.metric.Accuracy())

4.2 訓練模型

使用訓練集對模型進行訓練,并通過測試集驗證模型的性能。

model.fit(train_dataset, epochs=10, batch_size=64, verbose=1)

model.evaluate(test_dataset, verbose=1)

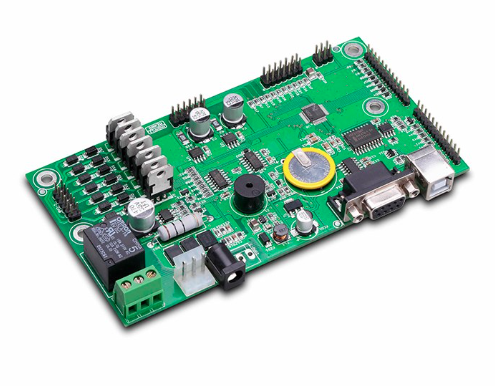

五、主控芯片選擇及作用

5.1 主控芯片型號

在深度學習應用中,尤其是涉及到邊緣計算或嵌入式系統時,選擇合適的主控芯片至關重要。對于基于PaddlePaddle的MNIST手寫數字識別項目,如果目標是部署到邊緣設備(如智能攝像頭、智能機器人等),則可能需要考慮一些低功耗、高性能的處理器。以下是一些可能的主控芯片型號:

NVIDIA Jetson系列:如Jetson Nano、Jetson Xavier NX等,這些芯片集成了GPU和CPU,專為加速深度學習推理和訓練設計,非常適合用于邊緣AI計算。

Intel Movidius Neural Compute Stick 2 (NCS2):雖然這更多是一個加速器而非完整的主控芯片,但它能夠與CPU結合使用,提供強大的深度學習推理能力,適用于需要低延遲和高性能的場景。

ARM Cortex-A系列:如Cortex-A72、Cortex-A76等,這些高性能的ARM處理器常用于智能手機、平板電腦和某些邊緣計算設備中,支持運行復雜的操作系統和深度學習框架。

RISC-V處理器:隨著RISC-V架構的興起,一些針對AI優化的RISC-V處理器也開始出現,它們可能提供更高的能效比和定制化能力。

5.2 在設計中的作用

計算性能:主控芯片的計算性能直接影響模型訓練和推理的速度。對于MNIST這樣的簡單任務,即使是中等性能的芯片也能勝任,但對于更復雜的深度學習應用,如圖像識別、語音識別等,則需要更高性能的芯片來支持。

能效比:在邊緣計算場景中,設備的電池壽命是一個重要考量因素。低功耗的主控芯片可以顯著延長設備的運行時間,減少充電頻率。

硬件加速:一些主控芯片內置了針對深度學習優化的硬件加速器(如GPU、NPU等),這些加速器可以大幅提升深度學習任務的執行效率,減少延遲。

系統集成:主控芯片通常還需要與其他硬件組件(如內存、存儲、傳感器等)協同工作。因此,選擇的主控芯片需要具備良好的系統集成能力,能夠輕松接入各種外設和接口。

軟件支持:主控芯片的軟件生態系統也是選擇時需要考慮的因素之一。一個成熟、活躍的社區和豐富的軟件資源可以大大簡化開發過程,降低開發成本。

六、部署與測試

在選擇了合適的主控芯片并完成了模型訓練后,下一步是將模型部署到目標設備上并進行測試。這通常包括以下幾個步驟:

模型轉換:將PaddlePaddle訓練好的模型轉換為目標設備支持的格式。這可能需要使用專門的轉換工具或庫。

模型優化:針對目標設備的硬件特性對模型進行優化,如量化、剪枝等,以減少模型大小和推理時間。

集成與部署:將優化后的模型集成到目標設備的軟件系統中,并進行必要的配置和調試。

性能測試:在目標設備上運行測試集,評估模型的推理速度和準確率,確保滿足應用需求。

實際應用:將部署好的設備投入實際應用場景,收集用戶反饋,并根據需要進行進一步的優化和改進。

七、結論

基于PaddlePaddle的MNIST手寫數字識別設計方案是一個典型的深度學習應用案例。通過選擇合適的主控芯片、精心設計網絡架構、優化數據處理和訓練過程,可以構建出高效、準確的數字識別系統。同時,將模型部署到邊緣設備并進行實際測試是確保系統可靠性和實用性的關鍵步驟。隨著深度學習技術的不斷發展和硬件性能的提升,我們有理由相信這類應用將在更多領域得到廣泛應用和推廣。

責任編輯:David

【免責聲明】

1、本文內容、數據、圖表等來源于網絡引用或其他公開資料,版權歸屬原作者、原發表出處。若版權所有方對本文的引用持有異議,請聯系拍明芯城(marketing@iczoom.com),本方將及時處理。

2、本文的引用僅供讀者交流學習使用,不涉及商業目的。

3、本文內容僅代表作者觀點,拍明芯城不對內容的準確性、可靠性或完整性提供明示或暗示的保證。讀者閱讀本文后做出的決定或行為,是基于自主意愿和獨立判斷做出的,請讀者明確相關結果。

4、如需轉載本方擁有版權的文章,請聯系拍明芯城(marketing@iczoom.com)注明“轉載原因”。未經允許私自轉載拍明芯城將保留追究其法律責任的權利。

拍明芯城擁有對此聲明的最終解釋權。

產品分類

產品分類

2012- 2022 拍明芯城ICZOOM.com 版權所有 客服熱線:400-693-8369 (9:00-18:00)

2012- 2022 拍明芯城ICZOOM.com 版權所有 客服熱線:400-693-8369 (9:00-18:00)